Le domande, l’IA e le risposte inaffidabili

Un nostro lettore ci ha scritto per una domanda che abbiamo ritenuto molto interessante per parlare di un tema che ci sta molto a cuore: l’affidabilità delle intelligenze artificiali.

Il lettore ci ha inviato una mail in cui ci racconta di un test che ha fatto con l’IA, a cui ha rivolto una domanda apparentemente banale:

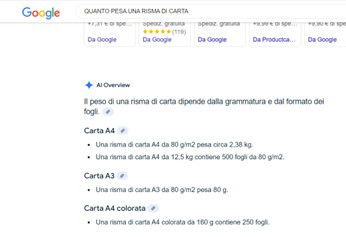

QUANTO PESA UNA RISMA DI CARTA

Poi ci ha screenshottato la risposta di Gemini AI che vedete qui sopra.

Che dice:

QUANTO PESA UNA RISMA DI CARTA

AI Overview

Il peso di una risma di carta dipende dalla grammatura e dal formato dei fogli.

Carta A4

Una risma di carta A4 da 80 g/m² pesa circa 2,38 kg.

Una risma di carta A4 da 12,5 kg contiene 500 fogli da 80 g/m².

Carta A3

Una risma di carta A3 da 80 g/m² pesa 80 g.

Carta A4 colorata

Una risma di carta A4 colorata da 160 g contiene 250 fogli.

Come rilevato dal nostro lettore, delle tre risposte che gli sono state date solo una era corretta, la prima (facendo riferimento ovviamente a una risma di carta standard da 80 grammi formato A4).

Quindi, siamo di fronte a un 33% di risposte corrette, e questo è male, dato come vediamo ormai usare le IA in tante situazioni.

Il problema

La responsabilità di questo va distribuita tra l’intelligenza artificiale e il modo in cui Google, in questo caso, ha sintetizzato la risposta che poi viene presentata in testa ai risultato di ricerca. Purtroppo l’IA di Google in questo caso non fa realmente conteggi, ma si limita a cercare e riassumere quanto ha trovato, senza minimamente preoccuparsi di verificare se quel dato sia o meno corretto. L’abbiamo già visto succedere pochissimo tempo fa parlando del prezzo di un Cornetto Algida. Il nostro lettore ha fatto qualcosa di prezioso: ha verificato, ha fatto i conti e usato lo spirito critico. Cose che, purtroppo, oggi sembrano opzionali. Così facendo ha scoperto che una semplice ricerca può produrre una percentuale di errore inquietante: 2 risposte sbagliate su 3.

Cosa imparare da questo caso?

Beh, ovviamente che dobbiamo diffidare sempre delle risposte “in evidenza”: il fatto che arrivino prima delle altre non significa che siano verificate e corrette, ma solo che siano quelle che vengono scelte dall’algoritmo, che premia struttura e sintesi, non verità. Inoltre riteniamo sia molto importante avere ben presente come funzionano le intelligenze artificiali: è fondamentale per rendersi conto ad esempio che possono sbagliare, anche su cose apparentemente semplici. Purtroppo chi conosce questi meccanismi può pilotare i motori di ricerca per far comparire i propri contenuti – anche se sono falsi, fuorvianti o complottisti – in cima alle ricerche. Basta scrivere bene e in modo “google-friendly”, et voilà.

Per concludere

Il problema non è se le IA possano darci risposte corrette oppure no: il problema è quando smettiamo di farci domande e di usare lo spirito critico perché tanto possiamo chiedere a Google o ChatGPT. Sia chiaro, questo non significa demonizzare le IA o spingervi a non usarle. Questa non è una crociata contro le AI – io stesso che scrivo le uso regolarmente – ma lo faccio con spirito critico, e verificando ogni informazione.

Ed è quello che consigliamo a tutti di fare.

Suggerisco a tutti questo video del sempre ottimo Dario Bressanini su come usare in maniera intelligente queste intelligenze artificiali:

@dario.bressanini Chiedere a #chatgpt #book #BookTok #AI #STEM #Scienze ♬ suono originale – Dario Bressanini

Non credo di dover aggiungere altro, ha già detto tutto Dario.

maicolengel at butac punto it

Se ti è piaciuto l’articolo, sostienici su Patreon o su PayPal! Può bastare anche il costo di un caffè!

Un altro modo per sostenerci è acquistare uno dei libri consigliati sulla nostra pagina Amazon, la trovi qui.

BUTAC vi aspetta anche su Telegram con il canale con tutti gli aggiornamenti e il gruppo di discussione, segnalazione e quattro chiacchiere con la nostra community.

L’articolo Le domande, l’IA e le risposte inaffidabili proviene da Butac – Bufale Un Tanto Al Chilo.